Next: 7.2 Esperimenti effettuati Up: 7. Interpolazione dei pesi Previous: 7. Interpolazione dei pesi Index

Entrambe queste tecniche hanno due grosse limitazioni:

La tecnica dell'interpolazione dei pesi, va a collocarsi proprio in quell'intervallo molto importante, tra 1 e 10 frasi di addestramento, in cui le altre tecniche non offrono buoni risultati.

La teoria su cui si fonda questo metodo, anch'essa basata sulla trasformazione del modello, è nettamente diversa rispetto alle strategie utilizzate in precedenza.

Il funzionamento di una rete neurale è regolato in base ai valori dei suoi bias e dei suoi pesi. Durante l'addestramento vengono lentamente variati al fine di ridurre l'errore compiuto sul pattern dato in ingresso, aumentando le prestazioni di riconoscimento per quel determinato pattern.

Avendo poche frasi di adattamento si possono scegliere due strade:

L'idea che sta alla base della strategia dell'interpolazione dei pesi è quella di riuscire, con poche frasi di un determinato parlatore, a trovare la variazione ottimale dei pesi, da applicare a tutta la rete o a parte di essa, al fine di avere un miglioramento delle prestazioni nel riconoscimento di quel parlatore.

Un'analisi della variazione dei pesi di una rete durante il training ha messo in evidenza che:

Analizzando uno specifico peso della rete, durante l'addestramento di un pattern, l'algoritmo di back-propagation calcola una variazione sub-ottimale del peso, al fine di permettere un riconoscimento migliore per quel pattern. Tale spostamento, sub-ottimo per quel determinato pattern, sicuramente non lo è per gli ulteriori patterns che verranno forniti alla rete.

|

Analizziamo i grafici della percentuale di riconoscimento nell'adattamento di J-LIN e di tutta la rete al variare del numero di frasi di addestramenti, si nota come durante le prime frasi di traning ci sia spesso un peggioramento delle prestazioni, dovuto alla polarizzazione di pesi sul pattern addestrato. La tecnica dell'interpolazione permette di ovviare a questo problema.

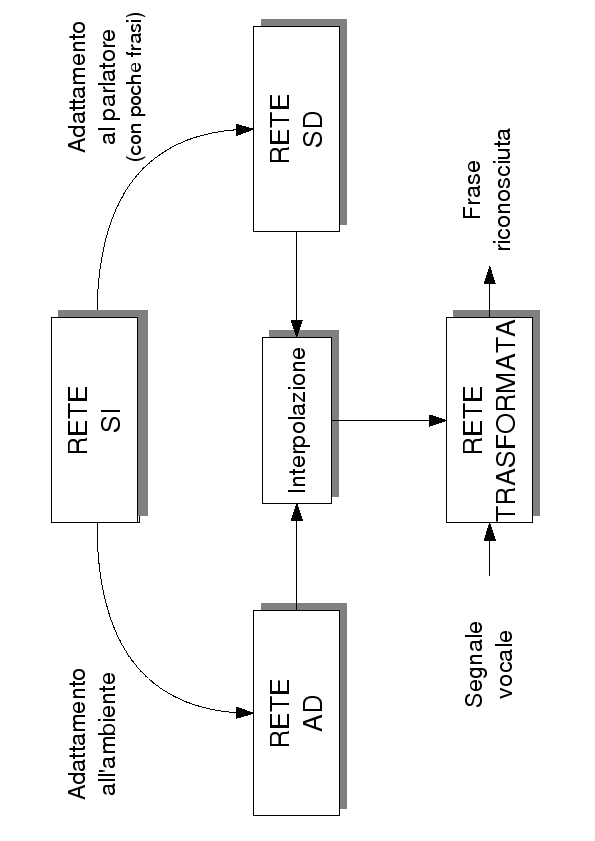

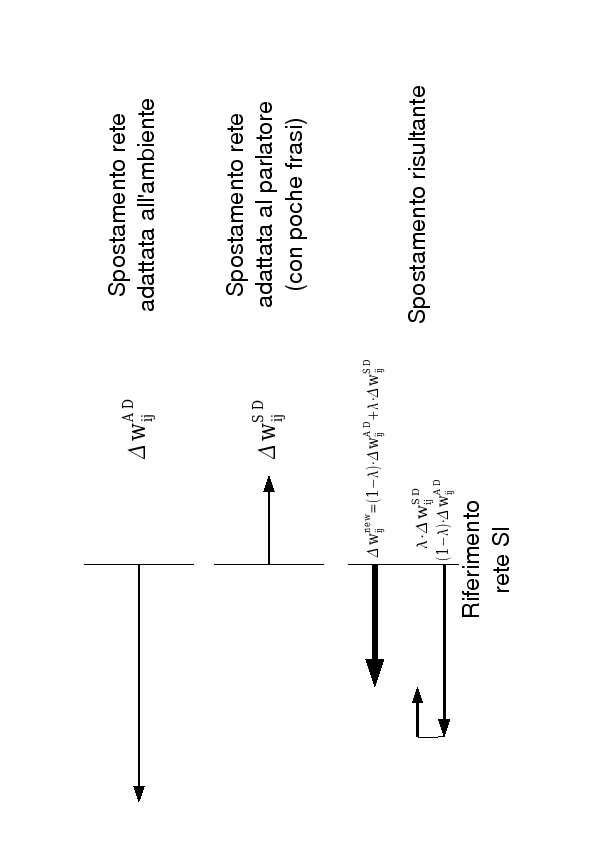

Come sempre la rete di partenza è una rete SI. Uno spostamento dei pesi proficuo non dipendente dal parlatore, è uno spostamento che applicato alla rete SI, possa dare dei risultati migliori e che non sia dipendente dal parlatore. Il più intuitivo di questi spostamenti è lo spostamento dei pesi per l'adattamento della rete SI all'ambiente. Spesso, infatti, è possibile ottenere per un'applicazione pratica di avere molto materiale di adattamento all'ambiente ed è sempre buona norma utilizzarlo al fine di rendere migliore il modello. A questo punto possiamo avere, per ogni peso della rete, il valore dello spostamento rispetto alla rete SI, al fine di ottenere una rete adattata all'ambiente. Partendo dalla stessa rete, per tutti i pesi, si può ricavare la variazione riferita al parlatore, sub-ottima per i patterns dati in ingresso.

|

Per regolare la prevalenza del modello adattato all'ambiente rispetto a quello adattato al parlatore si è utilizzata la variabile ![]() , che permette un'interpolazione tra le due variazioni dei pesi.

Siano

, che permette un'interpolazione tra le due variazioni dei pesi.

Siano

![]() la variazione della rete adattata all'ambiente rispetto alla rete SI per il peso

la variazione della rete adattata all'ambiente rispetto alla rete SI per il peso ![]() e

e

![]() la variazione della rete adattata al parlatore rispetto alla rete SI per il peso

la variazione della rete adattata al parlatore rispetto alla rete SI per il peso ![]() , la nuova variazione da applicare alla rete SI sarà data da:

, la nuova variazione da applicare alla rete SI sarà data da:

L'indice ![]() ottimale per l'interpolazione è collegato direttamente con il numero di frasi di training del modello. Si rimanda ai dati sperimentali per una trattazione più accurata sulla scelta del

ottimale per l'interpolazione è collegato direttamente con il numero di frasi di training del modello. Si rimanda ai dati sperimentali per una trattazione più accurata sulla scelta del ![]() ottimo.

ottimo.

L'interpolazione dei pesi può essere applicata per i pesi di tutta la rete o per LIN e J-LIN. In questo caso l'adattamento all'ambiente e al parlatore sarà effettuato solo per i livelli LIN e J-LIN, e anche l'interpolazione verrà eseguita solo per i pesi e per i bias a loro riferiti.

Stefano Scanzio 2007-10-16